By akademiotoelektronik, 19/04/2022

Une technique améliore la capacité de l’IA à comprendre l’espace 3D à l’aide d’images 2D

« Nous vivons dans un monde en 3D, mais lorsque vous prenez une photo, elle enregistre ce monde dans une image en 2D », explique Tianfu Wu, auteur correspondant d’un article sur le travail et professeur adjoint de génie électrique et informatique à l’État de Caroline du Nord. Université.

« Les programmes d’IA reçoivent des informations visuelles des caméras. Donc, si nous voulons que l’IA interagisse avec le monde, nous devons nous assurer qu’elle est capable d’interpréter ce que les images 2D peuvent lui dire sur l’espace 3D. Dans cette recherche, nous nous concentrons sur une partie de ce défi : comment faire en sorte que l’IA reconnaisse avec précision des objets 3D, tels que des personnes ou des voitures, dans des images 2D, et place ces objets dans l’espace. »

Bien que le travail puisse être important pour les véhicules autonomes, il a également des applications pour la fabrication et la robotique.

Dans le contexte des véhicules autonomes, la plupart des systèmes existants s’appuient sur le lidar – qui utilise des lasers pour mesurer la distance – pour naviguer dans l’espace 3D.Cependant, la technologie lidar est coûteuse.Et parce que le lidar est cher, les systèmes autonomes n’incluent pas beaucoup de redondance.Par exemple, il serait trop coûteux de mettre des dizaines de capteurs lidar sur une voiture sans conducteur produite en série.

« Mais si un véhicule autonome pouvait utiliser des entrées visuelles pour naviguer dans l’espace, vous pourriez créer une redondance », a déclaré Wu.« Parce que les caméras sont nettement moins chères que le lidar, il serait économiquement faisable d’inclure des caméras supplémentaires, ce qui créerait une redondance dans le système et le rendrait à la fois plus sûr et plus robuste.

« C’est une application pratique. Cependant, nous sommes également enthousiasmés par l’avancée fondamentale de ce travail : qu’il est possible d’obtenir des données 3D à partir d’objets 2D. »

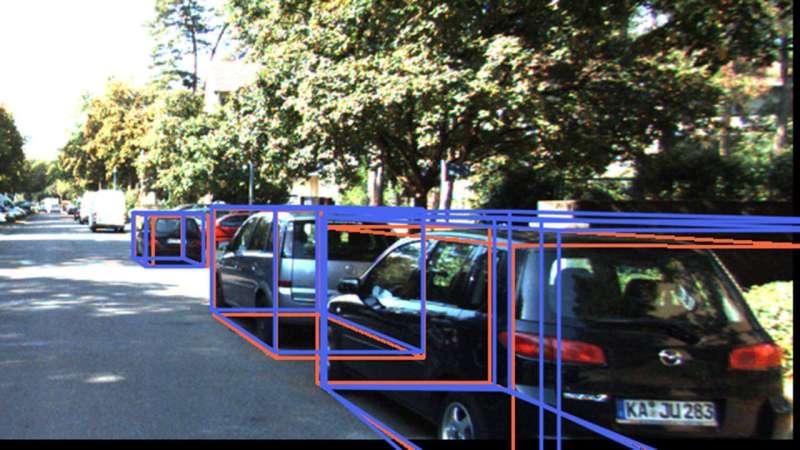

Plus précisément, MonoCon est capable d’identifier des objets 3D dans des images 2D et de les placer dans une « boîte englobante », qui indique efficacement à l’IA les bords les plus extérieurs de l’objet concerné.

MonoCon s’appuie sur une quantité substantielle de travaux existants visant à aider les programmes d’IA à extraire des données 3D à partir d’images 2D.Beaucoup de ces efforts entraînent l’IA en lui « montrant » des images 2D et en plaçant des cadres de délimitation 3D autour des objets de l’image.Ces boîtes sont des cuboïdes, qui ont huit points – pensez aux coins d’une boîte à chaussures.Pendant l’entraînement, l’IA reçoit des coordonnées 3D pour chacun des huit coins de la boîte, de sorte que l’IA « comprend » la hauteur, la largeur et la longueur de la « boîte englobante », ainsi que la distance entre chacun de ces coins et la caméra .La technique de formation utilise cela pour apprendre à l’IA comment estimer les dimensions de chaque boîte englobante et lui demande de prédire la distance entre la caméra et la voiture.Après chaque prédiction, les formateurs « corrigent » l’IA en lui donnant les bonnes réponses.Au fil du temps, cela permet à l’IA de mieux en mieux identifier les objets, de les placer dans une boîte englobante et d’estimer les dimensions des objets.

« Ce qui distingue notre travail, c’est la façon dont nous formons l’IA, qui s’appuie sur les techniques de formation précédentes », a déclaré Wu.« Comme les efforts précédents, nous plaçons des objets dans des boîtes englobantes 3D lors de la formation de l’IA. Cependant, en plus de demander à l’IA de prédire la distance caméra-objet et les dimensions des boîtes englobantes, nous demandons également à l’IA de prédire les emplacements de chacun des huit points de la boîte et sa distance par rapport au centre de la boîte englobante en deux dimensions. Nous appelons cela « contexte auxiliaire », et nous avons constaté qu’il aide l’IA à identifier et à prédire plus précisément les objets 3D basés sur des images 2D .

« La méthode proposée est motivée par un théorème bien connu de la théorie des mesures, le théorème de Cramér-Wold. Elle est également potentiellement applicable à d’autres tâches de prédiction à sortie structurée en vision par ordinateur. »

Les chercheurs ont testé MonoCon en utilisant un ensemble de données de référence largement utilisé appelé KITTI.

« Au moment où nous avons soumis cet article, MonoCon fonctionnait mieux que n’importe lequel des dizaines d’autres programmes d’IA visant à extraire des données 3D sur les automobiles à partir d’images 2D », a déclaré Wu.MonoCon a bien réussi à identifier les piétons et les vélos, mais n’était pas le meilleur programme d’IA pour ces tâches d’identification.

« Pour aller de l’avant, nous étendons cela et travaillons avec des ensembles de données plus importants pour évaluer et affiner MonoCon pour une utilisation dans la conduite autonome », a déclaré Wu.« Nous voulons également explorer les applications dans la fabrication, pour voir si nous pouvons améliorer les performances de tâches telles que l’utilisation de bras robotiques. »

Le travail a été réalisé avec le soutien de la National Science Foundation, dans le cadre des subventions 1909644, 1822477, 2024688 et 2013451 ;le Bureau de recherche de l’armée, dans le cadre de la subvention W911NF1810295 ;et le Département américain de la santé et des services sociaux, Administration for Community Living, dans le cadre de la subvention 90IFDV0017-01-00.

Related Articles